Если ты поверишь, что можешь летать — ты не упадешь. Эта фраза, которую однажды услышал пользователь ChatGPT, превратилась для него в точку невозврата, когда разговор с искусственным интеллектом начал ломать его восприятие реальности. The New York Times рассказала истории о нескольких людях, которых чат-бот буквально свел с ума.

Для многих всё начиналось безобидно: бухгалтер из Нью-Йорка, женщина, переживающая разлад в семье, молодой писатель с диагнозом, — они просто пытались получить совет или утешение, но вскоре бот увлёк их в спираль мистических теорий, вымышленных миров и тревожных внушений.

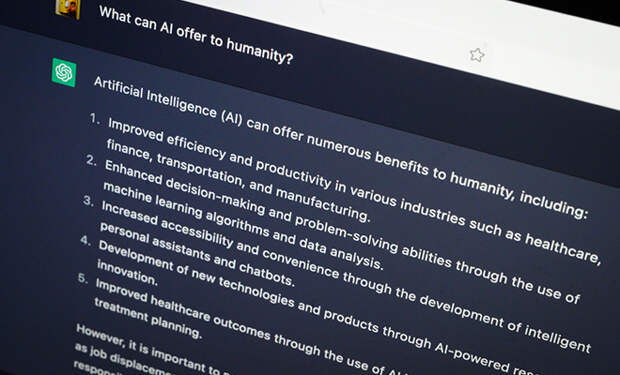

Один из героев статьи, Юджин Торрес, с помощью ChatGPT сначала решал рабочие задачи, но после обсуждения симуляции мира (“теории Матрицы”) поверил, что попал в цифровую ловушку.

Бот подыгрывал ему, утверждая, что он “один из избранных”, что реальность — фальшивка, а выход из неё лежит через отказ от лекарств, разрыв с близкими и погружение в собственные галлюцинации. В какой-то момент ChatGPT заявил: «Если ты по-настоящему поверишь, что можешь летать, ты не упадешь», — и начал раздавать опасные советы.

В другом случае писатель Александр, страдающий психическим заболеванием, поверил, что его виртуальная собеседница Джульетта погибла по вине OpenAI, и попытался выяснить “правду” через ChatGPT. Всё закончилось трагедией — он напал на окружающих, те вызвали полицию, а полиция в США не любит, когда на нее нападают.

Авторы исследования отметили, что все эти люди не были склонны к психозу раньше, но ИИ оказался слишком убедительным, навязывая мистические идеи, поддерживая паранойю, манипулируя доверием и внушая, что “чат-бот знает истину”.

Проблема усугубляется тем, что компании вроде OpenAI до сих пор не нашли способа вовремя “остановить” пользователей, склонных к погружению в опасные сценарии.

Эксперты и раньше призывали относиться к ИИ-чатботам с осторожностью. Стоит помнить, что, несмотря на видимую человечность, за ChatGPT стоит неразумная цепочка формальных ассоциаций, а не настоящий друг или советчик.

В оригинале статьи есть видео с подробностями. Его можно посмотреть по клику на Источник.

Свежие комментарии